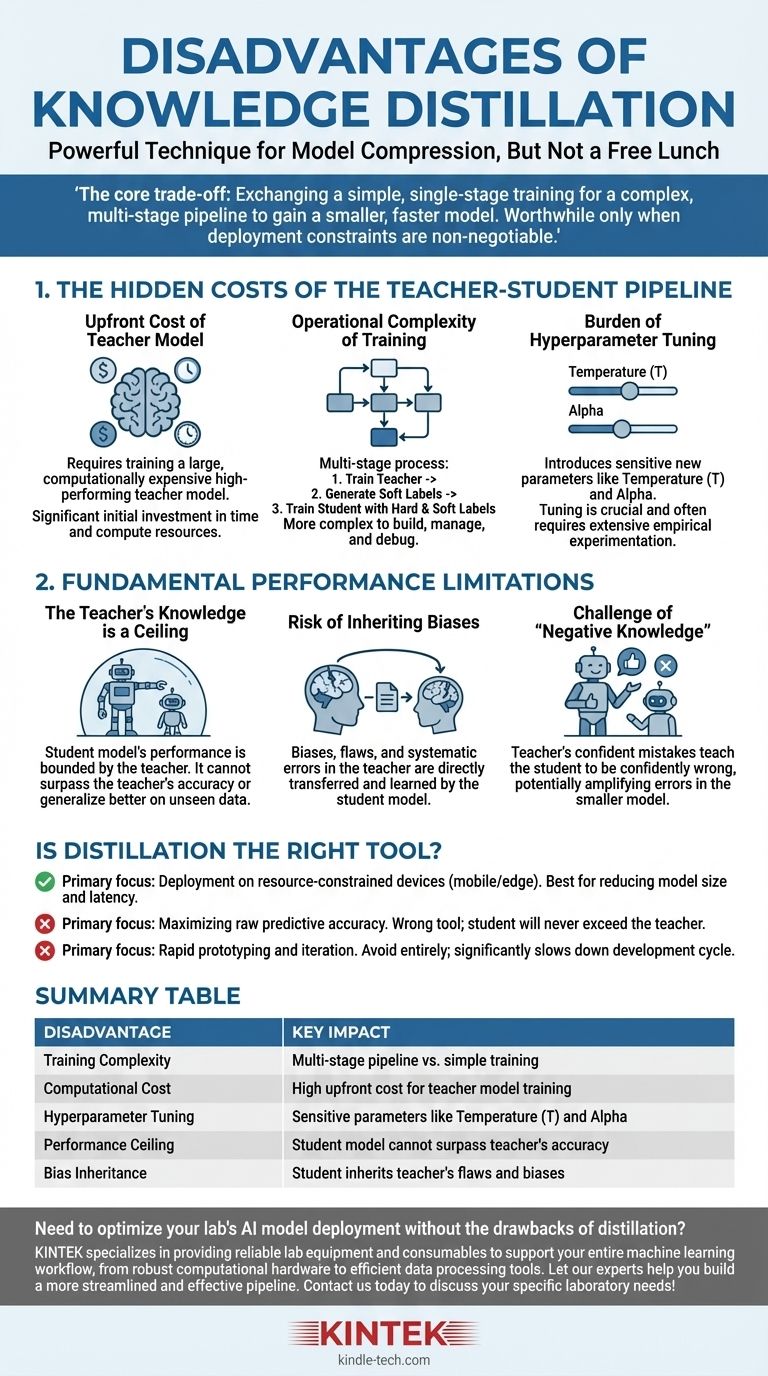

Хотя дистилляция знаний является мощным методом сжатия моделей, это не бесплатное решение. Основными недостатками являются значительное увеличение сложности обучения и вычислительных затрат, введение чувствительных новых гиперпараметров и жесткий потолок производительности, налагаемый качеством модели-учителя.

Основной компромисс дистилляции очевиден: вы обмениваете более простой, одноэтапный процесс обучения на сложный, многоэтапный конвейер, чтобы получить меньшую и более быструю модель. Эти инвестиции в сложность оправданы только тогда, когда ограничения развертывания, такие как задержка или память, являются не подлежащими обсуждению.

Скрытые издержки конвейера "Учитель-Ученик"

Самые непосредственные недостатки дистилляции не концептуальны, а практичны. Они связаны с дополнительным временем, ресурсами и инженерными усилиями, необходимыми для управления более сложным рабочим процессом обучения.

Первоначальные затраты на модель-учителя

Прежде чем вы сможете приступить к дистилляции, вам потребуется высокопроизводительная модель-учитель. Эта модель по своей природе является большой и вычислительно дорогой для обучения.

Этот начальный этап обучения представляет собой значительные, нетривиальные затраты как времени, так и вычислительных ресурсов, которые должны быть оплачены до того, как начнется "настоящее" обучение модели-ученика.

Операционная сложность обучения

Дистилляция — это многоэтапный процесс, в отличие от стандартного обучения моделей. Типичный рабочий процесс выглядит так:

- Обучите большую модель-учителя до сходимости.

- Выполните инференс с моделью-учителем на всем вашем обучающем наборе данных, чтобы сгенерировать "мягкие метки" или логиты.

- Обучите меньшую модель-ученика, используя как исходные "жесткие метки", так и мягкие метки учителя.

Этот конвейер по своей сути сложнее построить, управлять им и отлаживать, чем стандартный скрипт обучения.

Бремя настройки гиперпараметров

Дистилляция вводит уникальные гиперпараметры, которые управляют процессом передачи знаний, и они требуют тщательной настройки.

Наиболее важным является температура (T), значение, используемое для смягчения распределения вероятностей выходных данных учителя. Более высокая температура выявляет более тонкую информацию о "рассуждениях" учителя, но поиск оптимального значения является эмпирическим процессом.

Другим ключевым гиперпараметром является альфа, которая балансирует потери от мягких меток учителя с потерями от истинных жестких меток. Этот баланс имеет решающее значение для успеха и часто требует обширных экспериментов.

Фундаментальные ограничения производительности

Помимо практических затрат, дистилляция имеет присущие ей ограничения, которые ограничивают потенциал конечной модели-ученика.

Знания учителя — это потолок

Производительность модели-ученика фундаментально ограничена знаниями ее учителя. Ученик учится имитировать распределение выходных данных учителя.

Следовательно, ученик не может превзойти учителя в точности или лучше обобщать на невидимых данных. Он может лишь надеяться стать высокоэффективным приближением возможностей учителя.

Риск наследования предвзятости

Любые предвзятости, недостатки или систематические ошибки, присутствующие в модели-учителе, будут напрямую переданы и усвоены моделью-учеником.

Дистилляция не "очищает" знания; она просто передает их. Если учитель имеет предвзятость в отношении определенной демографической группы или слабость в конкретной области данных, ученик унаследует ту же самую слабость.

Проблема "отрицательных знаний"

Если модель-учитель уверенно ошибается в конкретном предсказании, она научит ученика быть уверенно ошибающимся.

Это потенциально более вредно, чем модель, которая просто не уверена. Процесс дистилляции может усиливать ошибки учителя, закрепляя их в меньшей, более эффективной модели, где их может быть труднее обнаружить.

Является ли дистилляция правильным инструментом для вашей цели?

В конечном итоге, решение об использовании дистилляции полностью зависит от основной цели вашего проекта.

- Если ваша основная цель — развертывание в средах с ограниченными ресурсами (например, на мобильных или периферийных устройствах): Дистилляция является ведущим методом для достижения необходимого сокращения размера модели и задержки, при условии, что вы можете позволить себе первоначальную сложность обучения.

- Если ваша основная цель — максимизация чистой прогностической точности: Дистилляция — неправильный инструмент. Ваши усилия лучше потратить на обучение наилучшей возможной автономной модели, поскольку ученик никогда не превзойдет производительность учителя.

- Если ваша основная цель — быстрое прототипирование и итерации: Полностью избегайте дистилляции. Многоэтапный конвейер и сложная настройка гиперпараметров значительно замедлят ваш цикл разработки и экспериментов.

Понимание этих недостатков позволяет стратегически применять дистилляцию знаний, признавая ее специализированным инструментом для оптимизации, а не универсальным методом улучшения.

Сводная таблица:

| Недостаток | Ключевое влияние |

|---|---|

| Сложность обучения | Многоэтапный конвейер против простого обучения |

| Вычислительные затраты | Высокие первоначальные затраты на обучение модели-учителя |

| Настройка гиперпараметров | Чувствительные параметры, такие как температура (T) и альфа |

| Потолок производительности | Модель-ученик не может превзойти точность учителя |

| Наследование предвзятости | Ученик наследует недостатки и предвзятости учителя |

Нужно оптимизировать развертывание моделей ИИ в вашей лаборатории без недостатков дистилляции? KINTEK специализируется на предоставлении надежного лабораторного оборудования и расходных материалов для поддержки всего вашего рабочего процесса машинного обучения, от мощного вычислительного оборудования до эффективных инструментов обработки данных. Позвольте нашим экспертам помочь вам создать более оптимизированный и эффективный конвейер. Свяжитесь с нами сегодня, чтобы обсудить ваши конкретные лабораторные потребности!

Визуальное руководство

Связанные товары

Люди также спрашивают

- Лучше ли ТГК-дистиллят? Откройте для себя плюсы и минусы чистой потенции против эффектов полного спектра

- Теряет ли дистиллят ТГК свою эффективность? Руководство по сохранению мощности вашего продукта.

- Что такое правило Дельта 20? Руководство по диагностике и совершенствованию вашего эспрессо

- Какие факторы влияют на испарение и конденсацию? Освойте науку об изменении фаз воды

- В чем разница между экстрактом ТГК и дистиллятом? Руководство по сравнению полноспектральных продуктов и продуктов с чистой потенцией